AI 모델 배포 6단계 체크리스트, 비용·모니터링·스케일링 실전 가이드

들어가며: 왜 지금 ‘AI 모델 배포’인가

- AI 모델 배포는 모델 성능보다 더 까다로운 운영의 문제예요. 실제 트래픽에서 안정성, 비용, 지연시간을 동시에 만족해야 하거든요. 이 글은 6단계 체크리스트로 배포 전 과정의 리스크를 줄이고, 팀 규모와 상관없이 바로 적용할 수 있는 실전 팁을 정리했어요.

- 각 단계마다 핵심 결정을 요약하고, 바로 참고할 수 있도록 내부/외부 자료 링크도 함께 배치했어요. 관련 배경 지식은 내부 카테고리에서 확장해 보세요. AI 카테고리 보러가기

1) 요구사항 정의와 비용 가설 세우기

- 제품/서비스 관점의 SLO를 먼저 정리해요. 목표 p95 지연시간, 최소 처리량(TPS/QPS), 가용성(예: 99.9%)을 명시하면 이후 모든 선택이 쉬워져요. AI 모델 배포는 기술보다 비즈니스 목표를 먼저 적는 게 핵심입니다.

- 워크로드 패턴을 수치로 표현하세요. 요청 길이(토큰/KB), 응답 평균 길이, 피크/비피크 트래픽 비율, 동시성 분포가 있어야 예산 산정이 가능해요.

- 비용 가설은 “단가 × 볼륨 = 총비용”으로 단순화합니다. GPU/CPU 시간, 메모리, 네트워크 egress, 스토리지, 토큰(LLM) 단가를 분리해 보고, 3가지 시나리오(낮음/보통/높음)를 만드세요.

- 의사결정을 뒷받침할 레퍼런스는 다음 자료를 참고해도 좋아요. 관련 기사 보기

2) 아키텍처 설계와 환경 선택

- 호스팅 모델을 결정해요. 완전관리형(API 위임), 서버리스, 컨테이너/Kubernetes, 온프레미스 중 하나 혹은 하이브리드예요. SLA/보안/비용을 기준으로 의사결정 매트릭스를 만들면 좋아요.

- 모델 형식과 추론 엔진을 고릅니다. FP16 vs INT8/4, 텐서RT/온nxRuntime/전용 런타임 등. AI 모델 배포에서 추론 엔진 최적화는 지연시간과 비용 모두에 큰 영향이 있어요.

- 네트워크 설계도 중요해요. 프라이빗 서브넷, NAT 게이트웨이, egress 비용, 캐시 계층(프롬프트/임베딩)을 포함하세요. 클라우드 카테고리

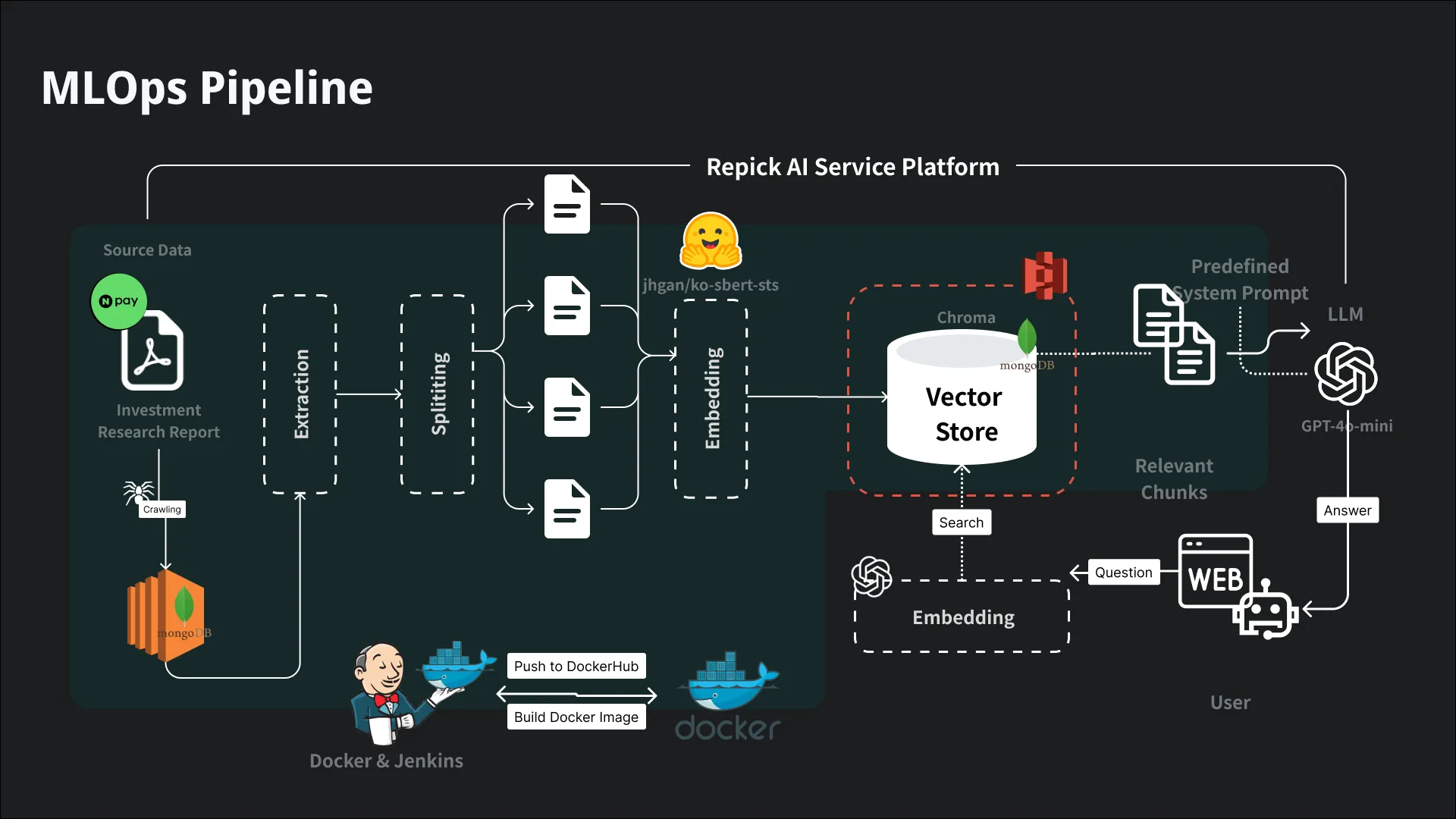

3) MLOps 파이프라인과 릴리스 전략

- CI/CD에 모델 레지스트리(버전, 메타데이터, 평가 점수)와 아티팩트 스토리지(가중치/토큰화기)를 통합하세요. 테스트 단계는 기능, 성능, 안전성(프롬프트 주입, PII 유출)을 분리해요.

- 릴리스는 블루/그린, 카나리, 점진적 트래픽 전환을 표준으로 삼습니다. AI 모델 배포에선 회귀(응답 퀄리티 저하)를 잡기 위해 A/B 오프라인 평가와 샘플 세트를 유지하세요.

- 엔지니어 논의와 사례는 커뮤니티 글도 유용해요. 백엔드 운영 팁 개발 카테고리

4) 모니터링·로깅·추적: SLI와 알림 기준

- 핵심 SLI를 정합니다. 지연시간(p50/p95/p99), 성공률(2xx/5xx), 토큰/요청당 비용, 캐시 적중률, 모델 응답 품질 점수(휴리스틱/피드백)를 최소 세트로 수집해요.

- 분산 추적(Trace)은 사용자 요청 → 프롬프트 구성 → 모델 호출 → 후처리 단계까지 이어져야 원인 진단이 빨라집니다. AI 모델 배포에선 스로틀/재시도/백오프가 어디서 걸리는지 추적하세요.

- 드리프트/데이터 품질 알람을 분리하고, 워드필터/PII 마스킹 결과를 별도로 로깅해 규제 대응을 준비합니다. IT 기초 카테고리 참고 기사

5) 비용 최적화: 고정비를 변동비로 바꾸기

- 모델/엔진 최적화: 양자화(INT8/4), 텐서RT, 배치/스트리밍 조합으로 지연시간과 비용을 함께 줄여요. 짧은 요청은 마이크로배치, 긴 응답은 스트리밍으로 첫 바이트를 앞당깁니다.

- 캐싱: 프롬프트/임베딩/결과 캐시를 계층화해 중복 호출을 줄이세요. AI 모델 배포에서 캐시 적중률 20→60%만 올려도 체감 비용이 크게 낮아집니다.

- 인프라: 스팟/프리엠티브 인스턴스+중단 대비 체크포인트, 스케줄링(야간 축소), 다중 AZ/리전 비용을 균형 있게 택합니다. 비용 관련 읽을거리

6) 스케일링 전략과 트러블슈팅

- 오토스케일링: HPA/KEDA로 CPU·메모리·큐 길이·토큰 처리량 지표를 묶고, 웜업(프리로딩)과 콜드스타트 완화를 병행하세요.

- 혼잡 제어: 큐 제한, 타임아웃, 서킷 브레이커, 토큰 상한, 재시도 지연(지수 백오프). AI 모델 배포에서 사용자 경험은 “빠른 실패와 명확한 메시지”로 보호돼요.

- 폴백 체인: 1순위 모델 실패 시 축소된 모델/요약 모드로 폴백, 캐시/줄이기 모드로 graceful degradation을 설계합니다. 운영 이슈 참고

6단계 요약 표

| 단계 | 핵심 포인트 | 체크아이템 |

| 1. 요구사항/비용 | SLO, 패턴, 비용 시나리오 | p95, 동시성, 단가표 |

| 2. 아키텍처 | 호스팅, 엔진, 네트워크 | 하이브리드, 캐시, 보안경계 |

| 3. MLOps | 레지스트리, 테스트, 카나리 | 품질 세트, 롤백 스위치 |

| 4. 모니터링 | SLI/알람, 추적 | p99, 에러 분류, PII 로그 분리 |

| 5. 비용 | 양자화, 캐시, 스팟 | 예산 알람, 예약/스팟 비율 |

| 6. 스케일링 | 오토스케일, 폴백 | 웜업, 서킷, 큐 제한 |

보안·규제·데이터 거버넌스

- PII/민감정보는 업로드 전 마스킹·비식별화. 키/토큰은 보안 비밀관리로 주입하고, AI 모델 배포 로그는 접근제어와 보존 주기를 구분하세요.

- 모델 출력의 저작권/상표/윤리 이슈에 대한 사전 가이드와 리뷰 체계를 마련합니다. 인시던트 대응(데이터 삭제, 차단, 보고) 플레이북도 필수예요. 법적 대응 가이드

벤치마킹과 운영 SOP

- 런북을 표준화하세요. 장애 정의 → 탐지 기준 → 에스컬레이션 → 커뮤니케이션 → 사후 RCA 순서로 문서화합니다. AI 모델 배포 특화 항목(퀄리티 레그, 토큰 폭증, 캐시 무효화)도 포함하세요.

- 벤치마크는 고정 시나리오(짧은/긴 프롬프트, 멀티턴, 대용량 파일)로 구성해 비교 가능성을 높입니다. 트렌드 해석 채용 트렌드 참고

“좋은 모델은 실험실에서 탄생하고, 훌륭한 제품은 운영에서 완성된다. AI 모델 배포는 그 중간을 이어주는 팀 스포츠다.”

현장에서 바로 쓰는 체크리스트 팁

- 문서 한 장으로 관리: SLO, 비용 가설, 아키텍처 다이어그램, 릴리스/롤백, 알람 기준, 폴백 순서를 A4 한 장에 요약해요.

- 리허설 필수: 카나리 5%로 실제 트래픽을 흘려보고, AI 모델 배포에서 가장 흔한 문제(콜드스타트, 큐 적체, 비용 초과)를 미리 맞아보세요.

- 지표 경계값: p95 800ms, 에러 1%, 비용/요청 상한 등 운영 한도를 명확히 합니다. 운영 사례 더 보기 참조 링크